Google ve diğer arama motorları kullanıcılarına en hızlı ve en kaliteli sonuçları sunmayı hedefler. Bunun için arama motorlarının botlarından faydalanır. Arama motorlarına ve diğer tarayıcılara ait botlar, internet sitelerinin taranması ve indekslenmesi amacıyla özel olarak tasarlanmış yazılımlar olma özelliğine sahiptir. Bu botlar web sayfalarını tarar ve kullanıcılara en doğru sonuçların en hızlı şekilde sunulmasına yardımcı olmak üzere dizinlere ekler.

Bununla birlikte bazı web sitesi sahipleri, web sitelerinde bulunan bazı sayfaların taranmasını ve dizine eklenmesini istemez. Bu noktada devreye giren robot.txt dosyası sayesinde arama motoru botlarının hangi bölümlere erişilebileceğine izin verme ve girişinin sınırlandırılacağı bölümleri belirleme imkanı elde edilir.

Arama motoru botlarına çeşitli direktifler verme amacıyla kullanılan, genellikle hangi sayfalara erişip hangilerine erişemeyeceklerini bildirmeyi sağlayan metin dosyası robot.txt olarak adlandırılır. Bu dosya sayesinde bazı sayfaların ya da sayfa gruplarının, hatta web sitesinin tamamının arama motoru botları tarafından taranması önlenebilir.

robots.txt dosyasının kullanımı, web sitesinde arama motoru botlarının erişmesi ve dizine eklemesi istenmeyen bazı özel sayfalar olduğunda gündeme gelebilir. Çok fazla sayıda web sayfası olması durumunda, arama motoru botlarının ayırdığı tarama bütçesini daha verimli bir şekilde kullanmak için de robots.txt kullanımı tercih edilebilir. Bu sayede arama motoru botlarının kaynaklarını web sitesindeki daha önemli sayfalar için kullanması sağlanabilir.

Web sitelerinin ana dizininde yer alan metin tabanlı bir dosya olan robots.txt, temelde arama motorlarının ve diğer tarayıcı botlarının, web sitesini ne kadar ve hangi bölgelerini tarayabileceğini belirleyen bir tür harita olma özelliğine sahiptir. Bu dosya sayesinde web sitesi sahipleri, arama motoru botlarına açacakları ve kapatacakları kapıların neler olduğunu son derece net bir şekilde belirleyebilirler.

İçindekiler

- 1 Robots.txt Nedir?

- 2 Robots.txt Dosyası Nasıl Çalışır?

- 3 Robots.txt Dosyası Nasıl Oluşturulur?

- 4 Robots.txt Komutları

- 5 Robots.txt Test Aracı

- 6 Search Console Kontrolü

- 7 Robots.txt Dosyası SEO İçin Neden Önemlidir?

- 8 Robots.txt Hakkında Dikkat Edilmesi Gerekenler

- 9 Search Console’a Robots.txt Nasıl Eklenir?

- 10 Robots.txt Hakkında Sıkça Sorulan Sorular

Robots.txt Nedir?

Robots.txt dosyası arama motoru botlarına sitenizin hangi bölümlerinin dizine eklenip, eklenmeyeceğini ve hangi sayfaların taranacağını söylemektedir. Arama motoru botları sitenize geldiğinde ilk olarak uğrayacağı yerler kök dizinde bulunan bu tür dosyalardır. Bu dosyalar sayesinde arama motoru botları sitenizi daha hızlı tarayabilmektedir.

Kök dizinde bulunan dosyalar arasında tahmin edebileceğiniz gibi robots.txt dosyası da bulunmaktadır. Kök dizinde bulunan dosyalar arasında ilk olarak taranan dosya robots.txt dosyasıdır. Bu dosya sayesinde arama motoru botları nereyi taramayacağını öğrenmektedir.

Robots.txt dosyası her sitede olması gereken, Google ve diğer arama motorlarının istediği bir dosyadır. Doğru şekilde hazırlanması ve doğru şekilde kullanılması çok önemlidir. Başta da söylediğimiz gibi yanlış kullanımı sitenize büyük etkiler bırakacaktır.

Robots.txt Dosyası Nasıl Çalışır?

İnternet ortamında web siteleri, arama motorları ve tarayıcı botlarla kesintisiz bir etkileşim içindedir. Robots.txt dosyası ise web sitesine gelen tarayıcı botlara, hangi sayfalara ve hangi dizinlere erişebileceklerine dair bir harita sağlar. Bu kapsamda, robots.txt dosyanın web sitesi sahiplerine ve yöneticilerine kontrol sağlama görevini üstlendiği ifade edilebilir.

Robots.txt dosyasının içeriği çoğu zaman “User-agent” ve “Disallow” direktifleriyle belirlenmektedir. ”User-agent”, hangi botun direktifleri takip edeceğini, “Disallow” ise botların erişiminin engellenmek istediği alanları belirtmektedir.

Bunun yanı sıra robots.txt dosyası yalnızca hangi bölgelere erişim izni verileceğini belirlemekle kalmayıp aynı zamanda “Allow” direktifiyle belirli dizinlere erişim izni vermesi de mümkündür. “Crawl Delay” ile botların web sitesini tarama hızını kontrol etmek, “Sitemap” direktifiyle ise arama motorlarına site haritası sunmak söz konusu olabilir.

Robots.txt dosyası web sitesi sahiplerine ve yöneticilerine, web sitesinin taranabilirliğini ve indekslenme sürecini kontrol etme yeteneği sunar. Bu nedenle robots.txt dosyasının web sitesi güvenliği, trafik yönetimi, kullanıcı deneyimi ve SEO stratejileri üzerinde kritik bir role sahip olduğunu söylemek mümkündür.

Robots.txt dosyasının doğru bir şekilde yapılandırılması sayesinde web sitesi sahipleri istenmeyen taramalardan kaçınabilir, önemli sayfaların öncelikli olarak indekslenmesini ve kullanıcı deneyiminin optimize edilmesini sağlayabilir.

Robots.txt Dosyası Nasıl Oluşturulur?

Robots.txt, web sitesi sahiplerine web sitelerinin arama motorları ve tarayıcı botlar tarafından nasıl taranacağını kontrol etme sürecinde yardımcı olan son derece etkili bir araçtır. Botlara hangi bölgelere erişim izni verileceğini belirleyen robots.txt dosyası aynı zamanda web sitelerinin güvenliğini ve performansını artırmaya yardımcı olur.

- Robots.txt dosyasını oluşturmak için not defteri ya da metin düzenleyici kullanabilirsiniz. Ancak bu dosya, “www.example.com/robots.txt” gibi bir konumda diğer bir deyişle web sitenizin ana dizininde yer almalıdır.

- Dosyanızın içine ilk olarak hangi bot ya da kullanıcı ajanı için kural koyduğunuzu belirtmek için “Use-agent” direktifini eklemelisiniz. “User-agent: Googlebot” ile Google botlarına özel bir kural oluşturduğunuzu belirtmeniz mümkün.

- Bir sonraki adımda belirlediğiniz botun ya da kullanıcı ajanın hangi bölgelere erişim izni ya da yasağı olacağını belirtmeniz gerekir. “Disallow” kullanarak herhangi bir dizini ya da sayfayı engellemeniz mümkün. “Allow” kullanarak ise herhangi bir dizine ya da sayfaya erişim verebilirsiniz.

- Aynı zamanda bazı özel durumları kontrol edebilmek için ileri düzey bazı direktifleri de kullanabilirsiniz. Botların tarama hızını kontrol etmek için “Crawl-delay” ve arama motorlarına site haritası sağlamak için “Sitemap” direktiflerinden faydalanabilirsiniz.

- Robots.txt dosyasını oluşturduktan sonra kaydetmeli ve web sitenizin ana dizinine yüklemelisiniz. Daha sonra bir tarayıcıda “www.example.com/robots.txt” adresine gitmeyi ve dosyanın doğru bir şekilde yüklenip yüklenmediğini kontrol etmelisiniz.

- Robots.txt dosyanızı oluşturduktan sonra arama motorları ve web sitesi analiz araçlarını kullanabilir, bu sayede web sitenizin indekslenme durumunu ve sergilediği performansı düzenli olarak kontrol edebilirsiniz. Bu adım, robots.txt dosyanızı güncel tutmanız ve web sitenizin yüksek performansla çalışmasını sağlamanız açısından çok önemlidir.

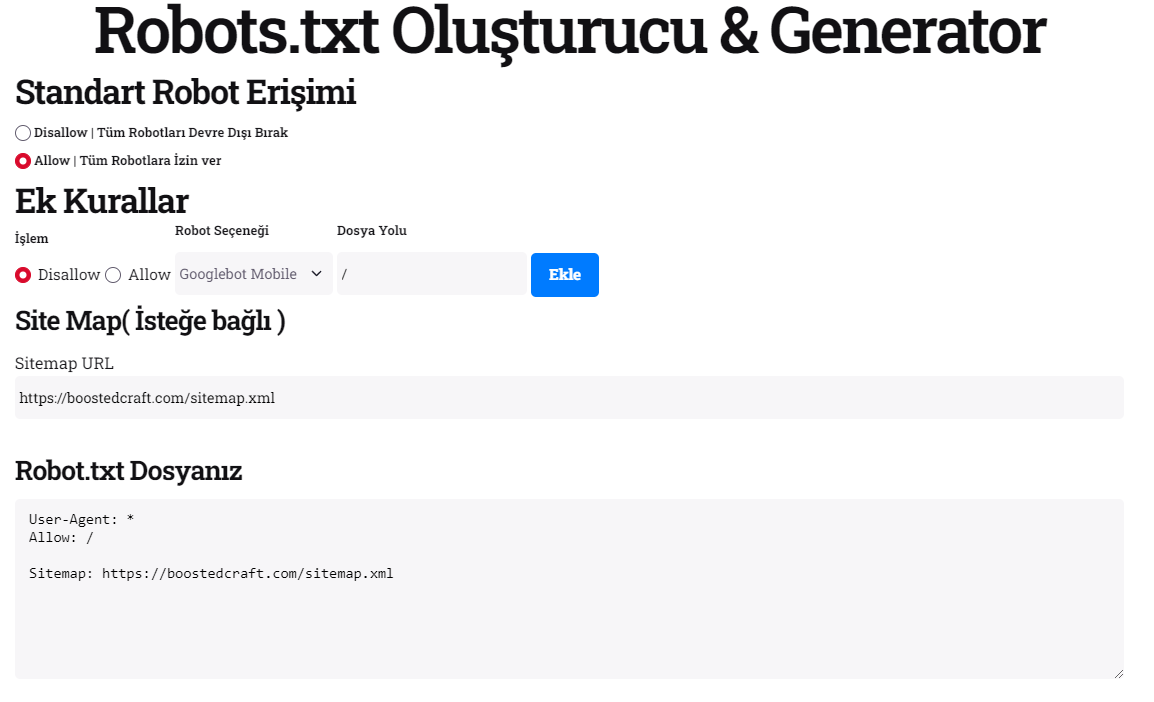

Boosted Craft ekibi tarafından geliştirilen robots.txt oluşturucu ile siteniz özelinde robots.txt dosyası oluşturabilirsiniz. Aracımızda botları engellemek veya izin vermek için seçmeniz yeterlidir. Kısa sürede kendinize ait bir robots.txt dosyası oluşturabilir ve sitenizin ana dizinine yükleyebilirsiniz.

Robots.txt Komutları

Robots.txt komutları, robots.txt dosyaları içerisinde kullanılmaktadır. Bu kodlar sayesinde arama motoru botlarını site içerisinde yönlendirebilirsiniz. Veya hangi bölümün taranacağını veya taranmayacağını aktarabilirsiniz.

Önemli Robots.txt Komutları

Web sitelerinin arama motorları ve tarayıcı botlar tarafından taranması, bu botlara hangi bölgelere erişim izni verileceğinin belirlenmesi, web sitesinin güvenliği, SEO performansı ve kullanıcı deneyimi açısından robots.txt komutları kritik bir öneme sahiptir.

- User-agent komutu, botları tanımlamak için kullanılır.

- Disallow komutu, belirli bir dizine ya da sayfaya erişimi engellemek için kullanılır.

- Allow komutu, belirli bir dizine ya da sayfaya erişim izni vermek için kullanılır.

- Crawl-delay komutu, belirli bir botun web sitesi tarama hızını kontrol etmek için kullanılır.

- Sitemap komutu, arama motorlarına site haritasının URL’sini belirtmek için kullanılır.

- Priority ve host komutları, belirli bir alt domain üzerinde çalışan botlara ya da belirli sayfaların önceliklerine özel direktifler sağlamak için kullanılır.

En önemli konu, robots.txt dosyasının bahsi geçen komutları doğru ve dengeli bir şekilde kullanmasıdır. Yanlış yapılandırma, web sitesinin indekslenmesini engelleyerek SEO performansı üzerinde olumsuz etkilere neden olabilir. Bu yüzde, robots.txt dosyası sürekli olarak gözden geçirilmeli ve güncellenmelidir.

Sonuç itibarıyla robots.txt dosyasında bulunan komutlar, web sitesi sahiplerine botların davranışlarını kontrol etme ve web sitesi güvenliğini, SEO performansını optimize etme konusunda son derece güçlü bir araç seti olarak kabul edilmelidir. Bu nedenle, robots.txt dosyasında komutların doğru bir şekilde kullanılması halinde web sitesi sahiplerinin sitelerini daha etkili bir şekilde yönetebilmesi ve arma motorlarıyla uyumlu hale getirebilmesi mümkündür.

Grup Komutları

User-agent: User-agent komutu arama motoru botlarının sitenize gelip, gelemeyeceğini belirtmektedir. Sitenizin tüm arama motoru botları tarafından taranmasını ve indexlenmesini istiyorsanız, User-agent: * komutunu kullanabilirsiniz. Eğer sadece Google’ın sitenizi taramasını istiyorsanız, User-agent: googlebot komutunu kullanarak bunu sağlayabilirsiniz.

Dizin Engelleme / İzin verme

Sitenizde bulunan bölümlerin taranıp, taranmayacağına karar vermektedir. Örnek vermek gerekirse sitenizde var olan resimlerin arama motoru botları tarafından taranmasını istemiyorsanız, disallow: /resim/ bu komutu kullanabilirsiniz. Bu komutu kullanmanız durumunda arama motoru botları wwww.ornekalanadi.com/resim/ URL’sine sahip olan bölümü taramayacak ve dizine eklemeyecektir.

Örnek:

User-Agent: *

disallow: /resim/

Dizin Engelleme / izin verme

Burada da aynı şekilde sitede bulunan sayfalara erişim izni verebilir veya sınırlama koyabilirsiniz. disallow: /deneme-url komutu ile ilgili URL taranmayacak ve dizine eklenmeyecektir. Allow komutu ise disallow komutlarını geçersiz kılar.

Örnek:

User-Agent: *

disallow: /deneme

allow: /deneme/blog.htmlBurada verdiğimiz örnek ışığında allow komutunda bulunan blog.html bağlantısı hariç diğer bölümlerin taranmasını kapatacaktır. Yani deneme bölümü tamamen taranmaya kapanacak ancak blog.html taranmaya devam edecektir.

Tarama Geciktirme (Crawl-delay)

Crawl-delay komutu, arama motoru botlarının tarama için harcayacağı zamanı sınırlandırabilirsiniz. Bu komut genellikle sunucu hatası ile karşı karşıya kalan veya çok yavaş açılan siteler tarafından kullanılmaktadır. Arama motoru botlarının siteye kötü puanlar vermesini istemiyorsanız, bu komutu kullanabilirsiniz.

User-Agent: *

crawl-delay: 15

Yukarıda komuta göre arama motoru botlarının 15 saniye aralıklarla bilgi çekmesini istedik.

Grup Dışı Komutlar

Grup dışı komutlar genellikle sitemap.xml için kullanılmaktadır. Arama motoru botları sitenizde ilk olarak kök dizine bakmakta ve ona göre sitede gezinmeye başlamaktadır. Robots.txt dosyanıza sitemap.xml URL’nizi ekleyerek botlara sitenizde hakkında bütün bilgileri verebilirsiniz. Botlar bu sayede sitenizde bulunan bütün URL’leri tek tek tarayabilir.

User-Agent: *

Sitemap: https://www.ornekalanadi.com/sitemap.xml

Robots.txt Dosyasında Kullanılabilen Özel Komutlar

Robots.txt dosyanızda kullanabileceğiniz bazı özel komutlarla sitenizde bulunan belirli sayfaları veya URLleri erişime kapatabilirsiniz.

user-agent: *

Disallow: /*?

Yukarıda ki örnekte, URL içerisinde (?) olan tüm bağlantılar arama motoru botlarınının erişime kapatılmış durumdadır.

User-agent: Googlebot

Disallow: /*.asp$Yukarıdaki örnekte ise .asp URL uzantısına sahip ($) işareti kullanılarak oluşturulan bağlantılar, Google botlarının erişimine tamamen kapatılmıştır.

Örnek Senaryolar

User-agent: *

Disallow: /- Web site tüm botlara açık

- Hiç bir sayfa botlar tarafından taranmasın

User-agent: *

Allow: /- Tüm site arama motoru botlarına açık

- Tüm sayfalar taranabilir ve indexlenebilir

User-agent: *

Disallow: /*.asp$- Tüm site arama motoru botlarına açık

- .asp ile biten URL’ler botların taramasına kapalı

- Komutta bulunan “$” işareti asp ile biten URL’leri tespit etmek için kullanılır.

- /* komutu ise URL öncesinde ne olursa olsun .asp içeren URL’leri engeller.

User-agent: Googlebot

Disallow: */boostedcraft- User-agent: Googlebot komutu google botlarının bundan sonra eklenecek komutları takip edeceği anlamına gelir.

- */ ile başlayan komut ise içerisinde boostedcraft içeren tüm değerlerin taramasını engelleyecektir.

Robots.txt Test Aracı

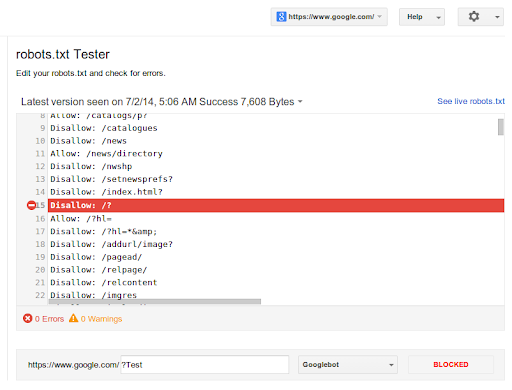

Robots.txt test aracı, oluşturduğunuz komutları veya genel olarak robot dosyasını test etmenizi sağlayan bir araçtır. Siteniz özelinde botlara engellemek istediğiniz bölümleri ilk önce bu araçta test ederek, doğru komutların tespitini yapabilir ve sitenize ekleme yapabilirsiniz.

Görselde gördüğünüz gibi üst bölüme istediğiniz komutları ekleyebilirsiniz. Daha sonrasında aşağıda bulunan URL bölümüne kontrol etmek istediğiniz URL adresini yazıp test et butonuna tıklamanız durumunda araç, size tarama izin verildiğini veya verilmediğini söylemektedir. Görselde oluşturulan örneğe göre /?Test URL’i taramaya kapatılmıştır.

Search Console Kontrolü

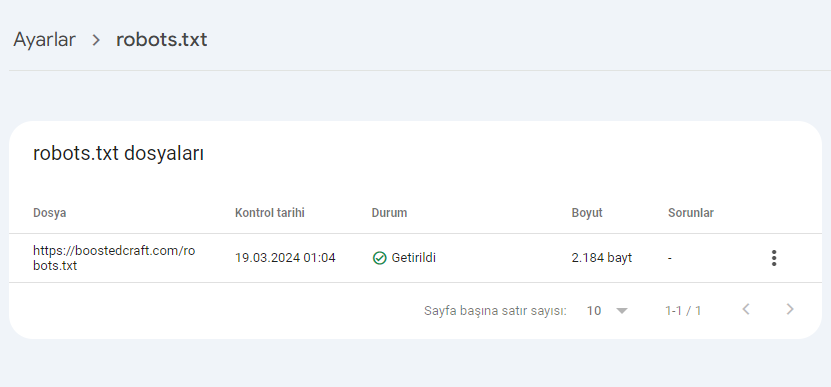

Oluşturulan Robots.txt dosyamızın google botları tarafından tespit edilip edilmediğini sırasıyla sitenizin bulunduğu GSC hesabınıza giriş yaptıktan sonra sol bölümde bulunan Ayarlar>Tarama>Robots.txt bölümlerine tıklamanız gerekiyor.

Adımları takip ettikten sonra çıkan sayfada oluşturduğumuz robots.txt dosyamızın konumu, kontrol tarihi, durumu, boyutu ve sorunlarını görebilmekteyiz. Eğer robots.txt dosyanızda bir sorun varsa burada size sorunla ilgili bilgi verecektir. Ayrıca genel olarak dosyanızın boyutunu, sorun olup olmadığını ve kontrol tarihini buradan kontrol edebilirsiniz.

Robots.txt dosyamız üzerinden taramaya kapatılan URL’lerimizi, Search console hesabımızda bulunan sayfalar bölümünden tespit edebiliyoruz. Buraya geçiş yapabilmek için, GSC hesabınıza giriş yaptıktan sonra sol bölümde bulunan Sayfa Sayısı>Robots.txt tarafından engellendi bölümüne tıklamanız durumunda size engellenen URL’leri gösterecektir. Bu bölümde robot dosyanız tarafından dizine eklenmesi engellenen URL’leri düzenli olarak kontrol edebilir ve ona göre aksiyon alabilirsiniz.

Robots.txt Dosyası SEO İçin Neden Önemlidir?

SEO yani Search Engine Optimization web sitelerinin arama motorları tarafından daha etkili bir şekilde anlaşılması, indekslenmesi ve sıralanması amacıyla gerçekleştirilen stratejileri ve teknikleri içeren konforlu bir süreçtir. Bu stratejiler arasında, web sitesinin tarama davranışını yönlendiren ve kontrol eden bir unsur olarak robots.txt dosyası çok önemlidir.

Robots.txt dosyasını kullanarak arama motorlarının web sitenizi taradığı sırada hangi bölgelere girebileceğini ve hangi sayfaları indeksleyebileceğini belirlemeniz mümkün. Böylece sitenizin içeriğini daha iyi organize edebilirsiniz. Kullanıcılar için önemli olan sayfaların indekslenmesini sağlayabilir, özel ya da gereksiz sayfaların indekslenmesini önleyebilirsiniz. Arama motorlarının web sitenizdeki önemli içeriklere odaklanması daha etkili sonuçlar almanızı sağlayabilir.

Robots.txt dosyası sayesinde web sitenizin içeriğini daha iyi yönetebilirsiniz. Özellikle büyük ölçekli web sitelerinde, belirli alanlarda ya da kategorilerde tarama yapılmasını sınırlayabilir, kaynakların daha etkili bir şekilde kullanılmasını sağlayabilirsiniz. Bu durum, arama motorlarına hangi içeriklerin öncelikli olduğunu belirleme ve önemsiz içerikleri filtreleme avantajı sayesinde SEO stratejileri için de önemlidir.

Aynı zamanda robots.txt dosyasını kullanarak hassas bilgiler içeren ya da güvenlikle ilgili sayfalara olan erişimi sınırlayabilir ve web sitenizin güvenliğini artırabilirsiniz. Kullanıcı giriş bilgilerini içeren bir dizini ya da özel bir sayfayı engelleyerek potansiyel güvenlik açıklarını minimize edebilir ve kullanıcı verilerini koruyabilirsiniz.

Crawl-delay komutuyla belirli bir botun web sitenizi tarama hızını kontrol edebilirsiniz. Böylece aşırı arama trafiğini önleyebilir ve sunucu kaynaklarını çok daha verimli bir şekilde kullanabilirsiniz. Tarama hızını ayarlamanız aynı zamanda web sitenizin performansının artmasını ve SEO üzerinde olumlu katkılarda bulunmasını sağlar.

Robots.txt dosyasını doğru bir şekilde yapılandırarak web sitenizin SEO performansını optimize edebilirsiniz. Arama motorlarına doğru bilgiler sağlayarak, web sitenizin daha hızlı indekslenmesini ve arama motoru sıralama sonuçlarının optimize edilmesini sağlayabilirsiniz.

Tüm bu nedenlere bağlı olarak robots.txt dosyası SEO stratejilerinin en önemli parçalarından biridir. Robots.txt komutlarını doğru bir şekilde kullanarak web sitenizi arama motorlarıyla uyumlu hale getirebilir, içeriklerinizi düzenleyebilir ve güvenlik önlemlerini alabilirsiniz. Robots.txt dosyası doğru ve dengeli bir şekilde kullanıldığında web sitenizin online varlığını güçlendirmeye yardımcı olan son derece önemli bir araçtır.

Robots.txt Hakkında Dikkat Edilmesi Gerekenler

- Robots.txt yeni kurulan her sitede bulunması gereken bir komut dosyasıdır. Bu dosya bulunmazsa arama motoru botları önüne gelen bütün URL’leri tarar ve dizine ekler. Bu siteniz için kötü durumlar yaratabilir.

- Dizine eklenmesini engellemek için, sayfalarınıza tek tek noindex etiketi yerleştirmek yerine Robots.txt dosyası oluşturarak bu zahmetten kurtulabilirsiniz.

- Robots.txt komutları doğru bir şekilde kurgulanmalıdır, yanlış kullandığını her kod sitenizin erişime kapatılmasına olanak sağlar.

Search Console’a Robots.txt Nasıl Eklenir?

Diğer rehber yazılarımıza göz atın:

Kaynaklar:

https://developers.google.com/search/docs/crawling-indexing/robots/intro?hl=tr

https://developers.google.com/search/docs/crawling-indexing/robots/create-robots-txt?hl=tr

Robots.txt Hakkında Sıkça Sorulan Sorular

Robots.txt dosyası, internet sitelerin kök dizininde bulunan ve arama motoru botlarına belirli sayfaları veya klasörleri taramamalarını söyleyen protokoldür.

Robots.txt dosyası, SEO çalışmalarının önemli bir parçasıdır. Bunun nedeni robot dosyası sayesinde tarama bütçenizi kontrol edebilir ve istenmeyen sayfaların indexlenmesini önleyebilirsiniz.

Robots.txt dosyası, internet sitenizin kök dizininde bulunması gerekmektedir. Örnek olarak sitemizin robot dosyası “https://boostedcraft.com/robots.txt” ile kök dizininde bulunmaktadır.